5 termini della SEO che spesso sono mal interpretati

Chi lavora in ambito SEO utilizza spesso una serie di termini, di cui conosce bene il significato, ma quando ci si rivolge a un pubblico di non addetti ai lavori, ci si trova di fronte a numerose incomprensioni. Vediamo insieme 5 termini che spesso vengono mal interpretati e per i quali è necessario spiegare approfonditamente le definizioni SEO.

Robots.txt

Per tutti

Il file robots.txt viene utilizzato per bloccare ai motori di ricerca l’accesso alle pagine web e ai contenuti.

La verità

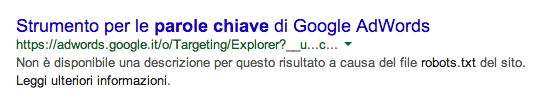

Il robots.txt viene utilizzato per impedire che il contenuto di una pagina o parte di un sito vengano scansionati e indicizzati dal motore, ma non la loro URL. Quando questo accade in SERP appare un risultato come questo

Questo perché il robots.txt non impedisce l’URL venga indicizzata, ma impedisce che il contenuto della pagina venga indicizzato. Se Google conosce la pagina grazie a un link o per altre vie, la URL verrà indicizzata e apparirà come nell’immagine.

Per evitare che una URL e il contenuto corrispondente vengano indicizzati bisogna utilizzare il meta tag robots impostato su noindex nella pagina stessa. Ciò significa aggiungere un codice come quello seguente nella sezione head della pagina web.

<meta name="robots" content="noindex,nofollow"> // per impedire che vengano considerati i link interni alla pagina

<meta name="robots" content="noindex,follow"> // per consentire che vengano considerati i link interni alla pagina

Approfondimenti

Google DNS

Per tutti

Molte persone pubblicano il loro sito senza modificare il noindex o il controllo dei login e presuppongono che Google non riesca a trovare il sito se non c’è un backlink.

La verità

La verità è che Google riconosce i siti per come sono quando vengono messi online. Questo significa che se si vuole evitare che vengano indicizzati, in quanto sono ancora in fase di sviluppo, bisogna impostare il controllo dei login e il noindex.

Quando, però, il sito viene messo online ed è pronto per l’indicizzazione tali sistemi devono essere adeguatamente modificati, altrimenti Google non potrà accedere alle pagine e di conseguenza non potrà indicizzarle.

Penguin, Panda e Penalizzazioni

Per tutti

Molti proprietari di siti pensano che Panda e Penguin siano nomi di penalizzazioni ed è comprensibile, in quanto causano perdite, a volte anche ingenti, alla visibilità del sito. In realtà, però, le uniche penalizzazioni operate da Google sono legate ad azioni manuali, quindi cosa sono esattamente Panda e Penguin?

La verità

Penguin e Panda sono i nomi di due importanti aggiornamenti dell’algoritmo di Google. Tali cambiamenti hanno portato a una rivalutazione generale dei siti web e di alcuni dei parametri che ne determinano il ranking. A seguito di tali aggiornamenti è possibile che il sito appaia penalizzato, ma in senso comune, ovvero che abbia perso posizioni e sia stata penalizzata la sua visibilità.

Quando si parla di penalizzazioni di Google ci si riferisce, invece, ad azioni manuali compiute da persone fisiche e segnalate in Webmaster Tools, a causa di vari fattori che rendono quel sito npn più meritevole della posizione che occupa in serp.

Approfondimenti

5+1 modi per evitare le penalizzazioni

Duplicazione

Per tutti

Molti pensano che duplicare un contenuto significhi copiare esattamente le parole di un paragrafo da una pagina web all’altra e pensano anche che questo sia causa di penalizzazione. In realtà entrambe le cose sono scorrette.

La verità

Google ha un modo molto più sofisticato per determinare se un contenuto è duplicato, quando trova due copie applica un filtro per escluderne una. Non si tratta di penalizzazione, nel senso inteso da Google, ma di perdita di visibilità. Tale filtro serve semplicemente a offrire un servizio migliore all’utente, che non deve trovarsi di fronte a risultati uguali, che non offrono nessun valore aggiunto alla loro ricerca.

In origine, secondo il brevetto originale di Google (US 8.015.162 B2), il rilevamento dei file duplicati o quasi duplicati avveniva utilizzando due algoritmi (Broder e Charikar), che lavoravano individuando le impronte digitali dei documenti (metodo Rabin). Oggi il metodo è stato migliorato, aggiungendo nuovi fattori di valutazione come il PageRank e la freschezza dei contenuti. Ogni documento viene inserito in un cluster, se a una query rispondono due documenti appartenenti allo stesso cluster (quindi quasi duplicati) avrà un migliore posizionamento quello ritenuto migliore (in virtù dei nuovi fattori dei valutazione). Ulteriori informazioni riguardo al metodo di valutazione dei contenuti duplicati vengono offerti dal nuovo brevetto (US 7366718 B1).

Approfondimenti

Strumenti di analisi dei contenuti duplicati

Page Rank

Per tutti

Il pageRank viene considerato un numero da 0 a 10, assegnato da Google, e che serve a indicare la qualità del sito in base all’algoritmo.

Questa definizione, però, non è corretta. Il PageRank è solo un valore pubblico che non ha molto significato, se non che se è 0 è male, se è 10 è ottimo; se scende c’è un problema, se sale si sta facendo bene.

La verità

In primo luogo, il PageRank che vedono gli utenti e ciò che usa Google sono due cose differenti. Innanzitutto il primo è la “Toolbar PageRank”. Inoltre, in secondo luogo, Google ha annunciato che il PageRank sta perdendo importanza, gli aggiornamenti dell’algoritmo lo considerano sempre meno per valutare i siti. Dato che i proprietari di siti lo usavano troppo come riferimento per valutare la qualità del proprio sito, Google ha preferito dirottarli su altre metriche più importanti.

Oggi il PageRank riguarda i backlink e la qualità degli stessi, non prende in considerazioni contenuti o altri fattori.

Per amor di precisione la formula del PageRank è:

PR(A) = (1-d) + d (PR(T1)/C(T1) + … + PR(Tn)/C(Tn))

Dove PR (A) è il PageRank della pagina A , PR (T1) è il PageRank della pagina T1 che ha link alla pagina A, C (T1) è il numero di link in uscita dalla pagina T1 e d è un coefficiente di smorzamento che può essere compreso tra 0 e 1. Come è facile capire non ci sono altri fattori che entrano in gioco, oltre ai backlink, nel calcolo del PageRank.

Fonte: Search Engine Watch